Obter um embasamento teórico mais robusto em machine learning + não ter encontrado blogs com o formato que eu gosto de ler = me veio a motivação para fazer uma série de posts sobre redes neurais com um pouco mais de profundidade!

Obter um embasamento teórico mais robusto em machine learning + não ter encontrado blogs com o formato que eu gosto de ler = me veio a motivação para fazer uma série de posts sobre redes neurais com um pouco mais de profundidade!

Biologia & Matemática

Começando em 1943. Uma fusão de biologia com matemática criou o paper A Logical Calculus of the Ideas Immanent In Nervous Activity [1]. A junção poderosa produziu um modelo abstrato para os neurônios artificiais criado pelos cientistas Warren S. McCulloch e Walter H. Pitts.

Eles observaram alguns comportamentos dos neurônios biológicos. Entre eles: a observação de fenômenos de refração de sinais caso os neurônios já houvessem sido excitados, um número fixo obrigatório de sinapses para que ele alterasse o seu estado (all-or-none), entre algumas outras características muito interessantes.

Ao final, foram descritas 5 suposições para que os cálculos dos cientistas pudessem ser coerentes. Então eles descreveram (abaixo uma tradução livre direto do paper) os tópicos:

A atividade do neurônio é um processo de “all-or-none“.

Um certo número fixo de sinapses precisam ser “disparadas” dentro de um período de adição latente para excitar o neurônio a qualquer momento. Este número independe de qualquer atividade prévia ou localização do neurônio.

O único delay significativo dentro de um sistema sináptico é o delay sináptico.

A atividade de um inibidor em um determinado momento pára completamente a atividade de um determinado neurônio naquele momento.

A estrutura da rede não se altera com o tempo.(mcculloh; pitts, 1943).

Abaixo segue uma esquemática do modelo de neurônio artificial:

A função após a soma, neste caso, aplica-se uma função simples:

- Pegue a soma dos inputs vezes os pesos (∑Ii . Wi):

- Se a soma for > que o limite T, y = 1;

- y = 0 caso contrário.

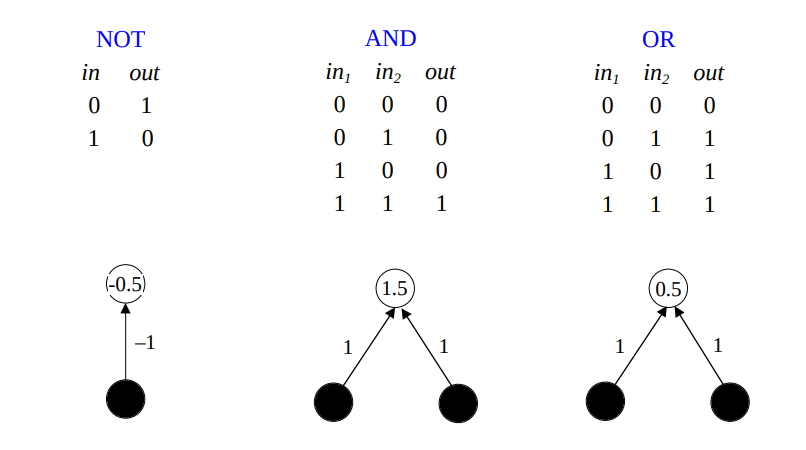

Ao colocarmos os parâmetros corretos neste modelo de neurônios artificiais podemos construir coisas interessantes, como portas lógicas:

Em seguida, Rosenblat desenvolveu, incluindo algumas melhorias no modelo proposto por McCulloch e Pitts, o Perceptron.

Toda essa teoria, que começou muitos anos atrás, possibilita, hoje, juntamente com os avanços tecnológicos no quesito de velocidade computacional e memória extremamente veloz, a construção de soluções para problemas muito complexos, que de certa forma ensinam o computador como agir dado uma entrada. Deixou de ser uma programação guiada a algoritmos rígidos e passou a ser uma programação por exemplos e aprendizagem.

É uma mistura de prazer e orgulho viver em uma época como a nossa.

Bom, é isso pessoal. Até o próximo post!

Links e leituras complementares

[1] http://www.cse.chalmers.se/~coquand/AUTOMATA/mcp.pdf

[2] http://www.cs.bham.ac.uk/~jxb/NN/l3.pdf

Leave a Reply